Tin Công Nghệ

Nvidia công bố GPU H200: 141GB HBM3e & băng thông 4,8 TB/s

Nvidia đã công bố dòng sản phẩm H200 và GH200 tại Supercomputing 23, đây là những con chip mạnh nhất mà Nvidia từng tạo ra, xây dựng trên kiến trúc Hopper H100 hiện có, nhưng bổ sung thêm bộ nhớ và khả năng tính toán nhiều hơn. Chúng được thiết lập để cung cấp năng lượng cho thế hệ siêu máy tính AI trong tương lai, với hơn 200 exaflop điện toán AI sẽ được đưa vào hoạt động trong năm 2024.

Mục Lục

Thông tin GPU H200 NVIDIA

Đây có lẽ là ngôi sao thực sự tại chương trình lớn này, Nvidia không cung cấp thông tin chi tiết về tất cả các thông số kỹ thuật, nhưng điểm chính dường như là sự gia tăng đáng kể về dung lượng bộ nhớ và băng thông trên mỗi GPU.

Bộ nhớ được nâng cấp

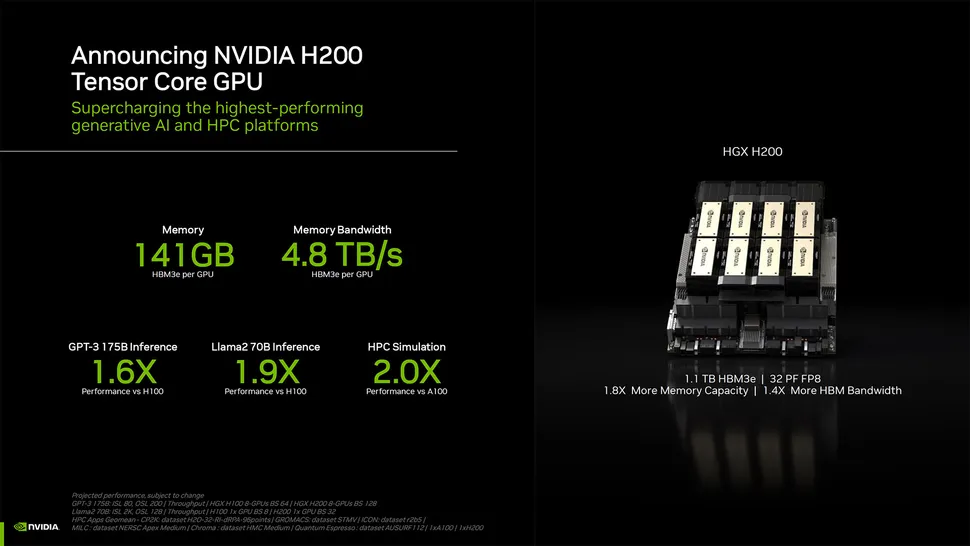

H200 được cập nhật có tổng bộ nhớ HBM3e là 141GB, chạy ở tốc độ hiệu dụng khoảng 6,25 Gbps, cho tổng băng thông 4,8 TB/s trên mỗi GPU trên sáu ngăn xếp HBM3e, đó là một cải tiến lớn so với H100 ban đầu, có 80GB HBM3 và băng thông 3,35 TB/s. Một số cấu hình nhất định của H100 đã cung cấp nhiều bộ nhớ hơn, như H100 NVL ghép nối hai bo mạch và cung cấp tổng bộ nhớ 188GB (94GB cho mỗi GPU). Nhưng so với biến thể H100 SXM, H200 SXM mới cung cấp dung lượng bộ nhớ nhiều hơn 76% và 43 % băng thông nhiều hơn.

Lưu ý rằng hiệu suất tính toán thô dường như không thay đổi nhiều, đồ họa duy nhất mà Nvidia hiển thị cho máy tính sử dụng cấu hình 8 GPU HGX 200 với tổng hiệu suất là “32 PFLOPS FP8”. H100 ban đầu cung cấp 3.958 teraflop FP8, vì vậy 8 GPU như vậy đã cung cấp khoảng 32 petaflop FP8.

H200 sẽ nhanh hơn bao nhiêu so với H100?

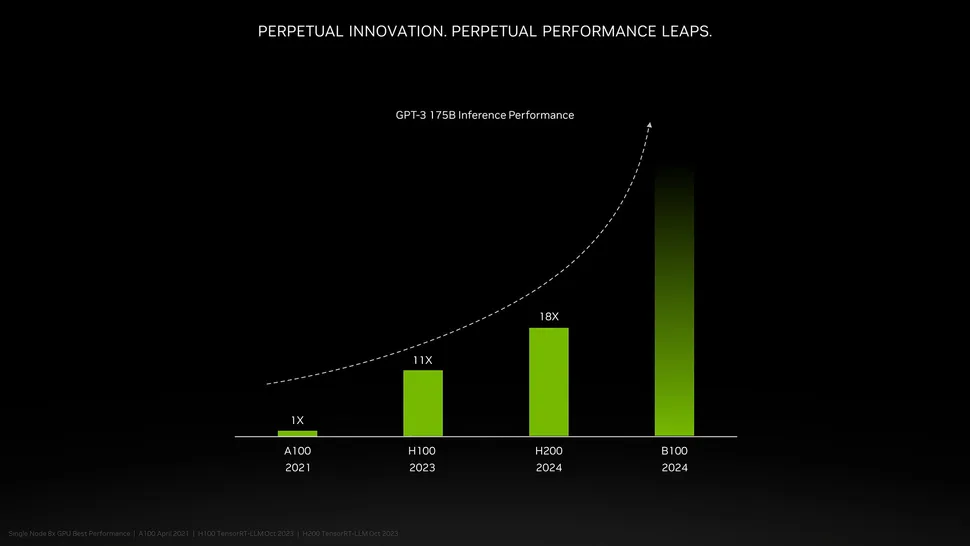

Điều đó sẽ phụ thuộc vào khối lượng công việc, đối với các LLM như GPT-3 được hưởng lợi nhiều từ dung lượng bộ nhớ tăng lên. Nvidia tuyên bố hiệu suất cao hơn tới 18 lần so với A100 ban đầu, trong khi H100 chỉ nhanh hơn khoảng 11 lần. Ngoài ra còn có một thông tin giới thiệu về Blackwell B100 sắp ra mắt, mặc dù hiện tại nó chỉ bao gồm một thanh cao hơn chuyển sang màu đen.

GPU GH200 NVIDIA sắp ra mắt

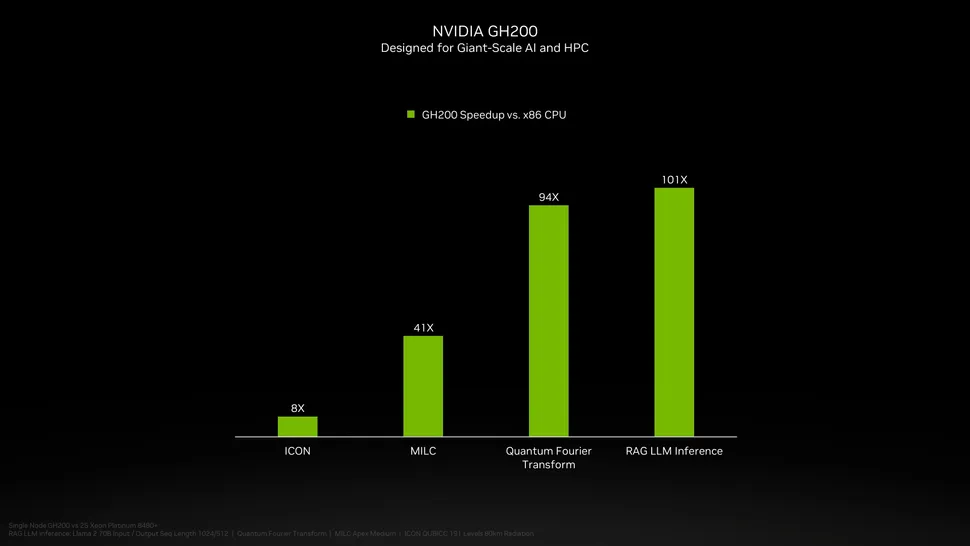

Đương nhiên, đây không chỉ là thông báo về GPU H200 được cập nhật, ngoài ra còn có GH200 mới sắp ra mắt, kết hợp GPU H200 với CPU Grace. Mỗi “siêu chip” GH200 sẽ chứa tổng cộng 624GB bộ nhớ, GH100 ban đầu kết hợp 480GB bộ nhớ LPDDR5x cho CPU với 96GB bộ nhớ HBM3, trong khi phiên bản mới sử dụng 144GB HBM3e đã thảo luận trước đó.

GH200 cũng sẽ được sử dụng trong các hệ thống HGX H200 mới, chúng được cho là “tương thích liền mạch” với các hệ thống HGX H100 hiện có. Nghĩa là HGX H200 có thể được sử dụng trong cùng một cài đặt để tăng hiệu suất và dung lượng bộ nhớ, mà không cần phải làm lại cơ sở hạ tầng.

>>> Xem thêm thông tin liên quan đến hệ thống máy chủ

Chip NVIDIA hoạt động trên siêu máy tính

Siêu máy tính Alps của Trung tâm Siêu máy tính Quốc gia Thụy Sĩ có thể sẽ là một trong những siêu máy tính Grace Hopper đầu tiên đi vào hoạt động trong năm tới và vẫn sử dụng GH100. Hệ thống GH200 đầu tiên đi vào hoạt động ở Mỹ sẽ là siêu máy tính Venado của Phòng thí nghiệm quốc gia Los Alamos. Hệ thống Vista của Trung tâm Máy tính Nâng cao Texas (TACC) cũng sẽ sử dụng CPU Grace và siêu chip Grace Hopper, đã được công bố hôm qua (13/11), nhưng không rõ đó là H100 hay H200.

Một số thông tin cho biết, hệ thống lắp đặt lớn nhất sắp tới là siêu máy tính Jupiter từ Trung tâm Siêu máy tính Jϋlich. Nó sẽ chứa “gần” 24.000 siêu chip GH200, với tổng cộng 93 exaflop tính toán AI (có lẽ đó là sử dụng số FP8, mặc dù hầu hết AI vẫn sử dụng BF16 hoặc FP16). Nó cũng sẽ cung cấp 1 exaflop tính toán FP64 truyền thống, sử dụng bo mạch “quad GH200” có bốn siêu chip GH200.

Một số thông tin cho biết, hệ thống lắp đặt lớn nhất sắp tới là siêu máy tính Jupiter từ Trung tâm Siêu máy tính Jϋlich. Nó sẽ chứa “gần” 24.000 siêu chip GH200, với tổng cộng 93 exaflop tính toán AI (có lẽ đó là sử dụng số FP8, mặc dù hầu hết AI vẫn sử dụng BF16 hoặc FP16). Nó cũng sẽ cung cấp 1 exaflop tính toán FP64 truyền thống, sử dụng bo mạch “quad GH200” có bốn siêu chip GH200.

Nvidia dự kiến sẽ có hơn 200 exaflop hiệu suất tính toán AI sẽ xuất hiện trong khoảng năm tới với các bản cài đặt siêu máy tính mới này.

Kết luận

Vừa rồi là những thông tin liên quan đến những dòng sản phẩm mới H200, GH200 vừa được công bố tại Supercomputing 23. Nhìn chung, đây là một số cập nhật lớn của NVIDIA khi hãng này tiếp tục dẫn đầu thế giới AI với các công nghệ phần cứng và phần mềm mạnh mẽ.

Sắp tới chúng tôi cũng vẫn sẽ cập nhật thêm nhiều tin tức công nghệ hấp dẫn hơn, các bạn đừng bỏ lỡ nhé!

Liên hệ ngay với chúng tôi để đặt mua Server AI