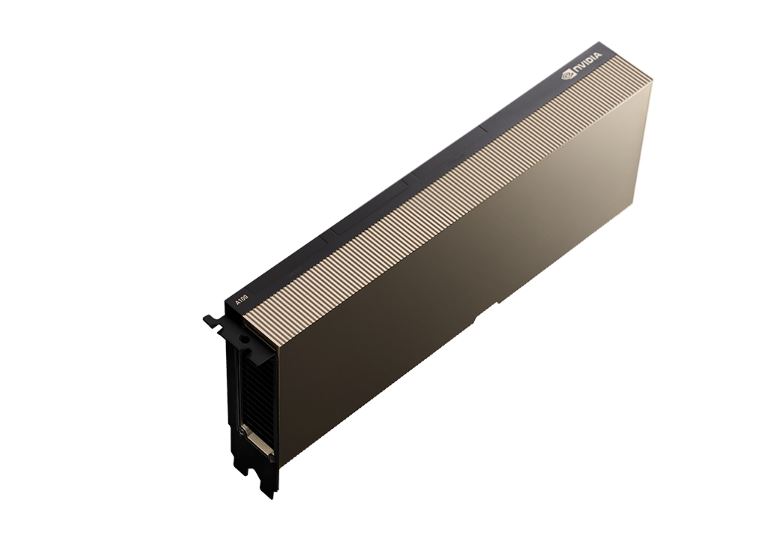

GPU NVIDIA A100 Tensor Core là một trong những dòng card đồ họa thế hệ mới, mang đến nhiều tính năng đa dạng hỗ trợ công việc đầy mượt mà. Để biết chi tiết về sản phẩm, Máy Chủ Việt mời bạn cùng theo dõi bài viết dưới đây!

Thông số kỹ thuật GPU NVIDIA A100 Tensor Core

| A100 80GB PCIe | A100 80GB SXM | |

| FP64 | 9.7 TFLOPS | |

| FP64 Tensor Core | 19.5 TFLOPS | |

| FP32 | 19.5 TFLOPS | |

| Tensor Float 32 (TF32) | 156 TFLOPS | 312 TFLOPS* | |

| BFLOAT16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | |

| FP16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | |

| INT8 Tensor Core | 624 TOPS | 1248 TOPS* | |

| GPU Memory | 80GB HBM2e | 80GB HBM2e |

| GPU Memory Bandwidth | 1,935 GB/s | 2,039 GB/s |

| Max Thermal Design Power (TDP) | 300W | 400W *** |

| Multi-Instance GPU | Up to 7 MIGs @ 10GB | Up to 7 MIGs @ 10GB |

| Form Factor | PCIe Dual-slot air-cooled or single-slot liquid-cooled | SXM |

| Interconnect | NVIDIA® NVLink® Bridge for 2 GPUs: 600 GB/s ** PCIe Gen4: 64 GB/s | NVLink: 600 GB/s PCIe Gen4: 64 GB/s |

| Server Options | Partner and NVIDIA-Certified Systems™ with 1-8 GPUs | NVIDIA HGX™ A100-Partner and NVIDIA-Certified Systems with 4,8, or 16 GPUs NVIDIA DGX™ A100 with 8 GPUs |

Tổng quan chung về GPU NVIDIA A100 Tensor Core

Trong bối cảnh công nghệ trí tuệ nhân tạo (AI), điện toán hiệu năng cao (HPC) và phân tích dữ liệu lớn ngày càng phát triển, nhu cầu về một nền tảng phần cứng mạnh mẽ, linh hoạt và tối ưu là điều không thể thiếu. NVIDIA A100 Tensor Core GPU, thuộc dòng sản phẩm kiến trúc Ampere của NVIDIA, chính là lời giải cho bài toán hiệu suất và khả năng mở rộng trong máy chủ AI và các trung tâm dữ liệu hiện đại.

Với khả năng xử lý mạnh mẽ, tính linh hoạt cao và các công nghệ mới tích hợp, NVIDIA A100 là lựa chọn lý tưởng cho:

- Huấn luyện và triển khai mô hình học sâu (Deep Learning)

- Mô phỏng khoa học, kỹ thuật, tài chính

- Hạ tầng AI-as-a-Service cho doanh nghiệp

- Các hệ thống AI tạo sinh và xử lý ngôn ngữ tự nhiên (LLM, NLP)

Điểm ưu việt ở GPU NVIDIA A100 Tensor Core

Kiến trúc Ampere thế hệ mới – nền tảng cho hiệu năng vượt trội

A100 được xây dựng dựa trên kiến trúc Ampere – nền tảng GPU tiên tiến nhất của NVIDIA thời điểm hiện tại. GPU này tích hợp Tensor Core thế hệ thứ ba, hỗ trợ nhiều định dạng số học như FP64, FP32, TF32, BFLOAT16, FP16, INT8 và INT4. Đây chính là yếu tố then chốt giúp A100 tăng tốc các tác vụ từ huấn luyện mô hình AI đến suy luận thời gian thực một cách hiệu quả.

Trong đó, chế độ TF32 (Tensor Float 32) đóng vai trò cực kỳ quan trọng, khi cho phép tăng tốc độ xử lý dữ liệu gấp nhiều lần so với định dạng FP32 truyền thống – mà không cần thay đổi mã nguồn của các mô hình AI hiện có.

So với thế hệ trước, NVIDIA A100 có thể mang lại hiệu suất gấp 20 lần, giúp rút ngắn thời gian huấn luyện mô hình AI, cải thiện tốc độ suy luận, đồng thời tăng tốc các ứng dụng tính toán phức tạp. Điều này giúp doanh nghiệp và tổ chức khoa học đẩy nhanh tiến độ nghiên cứu, triển khai các giải pháp nhanh chóng hơn.

>>>Máy chủ Dell R760 đang làm mưa làm gió trên thị trường!

Bộ nhớ HBM2e siêu tốc – tối ưu cho mô hình AI khổng lồ

NVIDIA A100 được trang bị bộ nhớ HBM2e có dung lượng lên đến 80GB, cung cấp băng thông lên tới 2.039 GB/s. Điều này cho phép GPU xử lý khối lượng dữ liệu khổng lồ trong thời gian ngắn, đặc biệt hữu ích trong các mô hình học sâu như GPT, DALL·E hoặc các hệ thống AI tạo sinh (Generative AI). Việc đào tạo và triển khai mô hình trở nên nhanh hơn, mượt mà hơn và tiết kiệm tài nguyên hơn.

Tính năng Multi-Instance GPU (MIG) – phân chia tài nguyên linh hoạt

Một tính năng nổi bật khác của A100 là Multi-Instance GPU (MIG) – công nghệ cho phép chia một GPU vật lý thành tối đa 7 GPU ảo độc lập, mỗi đơn vị đều có bộ nhớ và lõi tính toán riêng. MIG giúp các doanh nghiệp và tổ chức tối ưu hóa hiệu suất phần cứng khi chạy nhiều tác vụ song song, đặc biệt là trong môi trường đám mây hoặc trung tâm dữ liệu đa nhiệm.

Với phiên bản NVIDIA A100 80GB, mỗi MIG instance có thể khai thác lên đến 10GB bộ nhớ – gấp đôi so với bản 40GB – giúp cải thiện khả năng xử lý và chia sẻ tài nguyên.

>>> Máy chủ HPE Gen11 không nên bỏ qua!

Kết nối siêu tốc với NVLink và NVSwitch

Để hỗ trợ các hệ thống cần nhiều GPU, A100 còn tương thích với NVLink thế hệ mới và NVSwitch, giúp kết nối các GPU lại với nhau với tổng băng thông lên tới 600 GB/s. Nhờ đó, các hệ thống HPC hoặc siêu máy tính có thể mở rộng dễ dàng mà không bị giới hạn về tốc độ truyền tải dữ liệu giữa các GPU.

Địa chỉ mua GPU A100 uy tín, chất lượng tại Việt Nam?

Nếu bạn đang phân vân chưa biết nên mua NVIDIA A100 ở đâu, vậy hãy đến Máy Chủ Việt, với cam kết chất lượng 100%, chắc chắn sẽ khiến bạn hài lòng.

Bên cạnh các dòng Card đồ họa, Máy Chủ Việt còn chuyên phân phối máy chủ chính hãng đến từ nhiều thương hiệu lớn, trong đó có máy chủ NVidia. Chính vì vậy, nếu bạn đang có nhu cầu nâng cấp hệ thống, hay muốn sở hữu những công nghệ quản lý tiên tiến nhất, hãy liên hệ đến website hoặc các kênh dưới đây để được hỗ trợ nhé!

- Website: https://maychuviet.vn/

- Hotline: 0867.111.333

- Email: kinhdoanh@maychuviet.vn

Đánh giá