Tin Công Nghệ

Dòng GPU Flex của Trung tâm dữ liệu Intel nhận Tensor mới

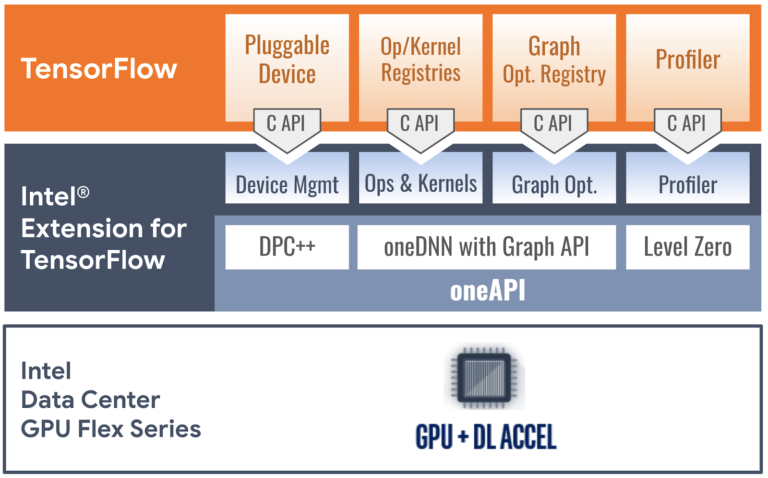

TensorFlow cho phép tạo một nền tảng cho các mô hình học máy AI để chuẩn bị, xây dựng, triển khai và thực hiện một số tùy chọn phần mềm và phần cứng. Gần đây, Google và Intel đã tạo ra một cách cho phép các nhà sản xuất phần cứng khác nhau phát hành sản phẩm hỗ trợ cho các thiết bị trung tâm dữ liệu mà không làm thay đổi mã gốc.

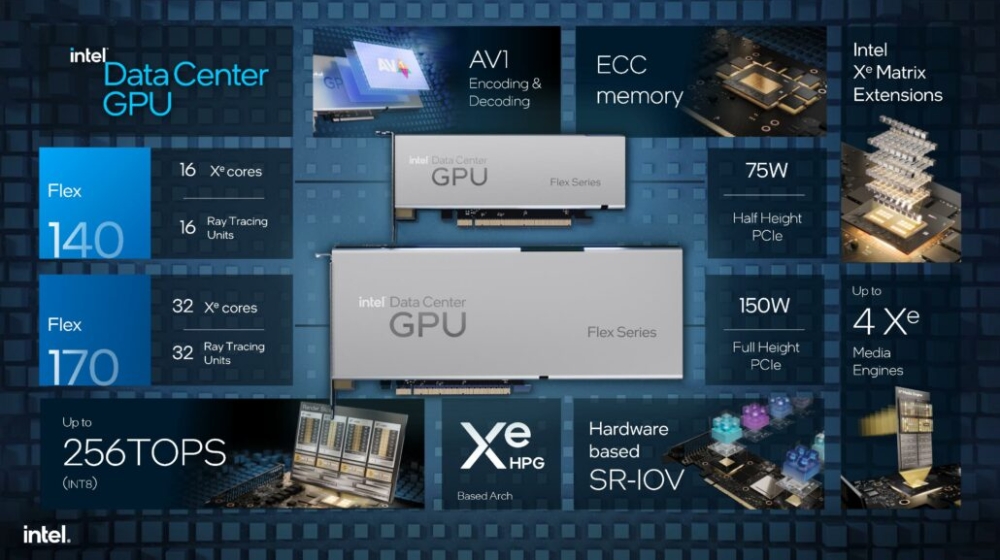

Cơ chế mới này được gọi là PluggableDevice. Hôm nay, Intel thông báo rằng họ đã thêm Dòng sản phẩm Intel Data Center GPU Flex vào dòng PluggableDevices, được gọi là Intel Extension for TensorFlow.

Các thành viên trong nhóm Intel và Google hợp lực để tạo ra khả năng tăng tốc TensorFlow mới thông qua Phần mở rộng Intel mới dành cho TensorFlow

Việc triển khai mới này cho Intel và TensorFlow sẽ cho phép phần cứng Intel Data Center GPU Flex Series và đồ họa Intel Arc của công ty. Nó tương thích với Linux và Hệ thống con Windows dành cho Linux bằng cách kết nối với oneAPI. OneAPI là tiêu chuẩn mô hình lập trình mã nguồn mở cho phép các nhà phát triển sử dụng các kiến trúc tăng tốc khác nhau.

Xem thêm một vài cpu cũ giá rẻ có đồ họa tích hợp

Plugin thêm, mặc dù đơn giản để khởi tạo, sẽ cho phép các nhà phát triển sử dụng các mô hình API C khác nhau kết hợp C ++ với các mô hình lập trình SYCL.

- Quản lý thiết bị: Các nhà phát triển của Intel và Google đã triển khai API StreamExecutor C của TensorFlow sử dụng C ++ với SYCL và một số hỗ trợ đặc biệt được cung cấp bởi thời gian chạy oneAPI SYCL (dự án DPC ++ LLVM SYCL). StreamExecutor C API xác định luồng, thiết bị, ngữ cảnh, cấu trúc bộ nhớ và các chức năng liên quan, tất cả đều có ánh xạ nhỏ tới các triển khai tương ứng trong thời gian chạy SYCL.

- Đăng ký op và hạt nhân: Kernel và đăng ký op của TensorFlow C API cho phép triển khai hạt nhân dành riêng cho thiết bị và các hoạt động tùy chỉnh. Để đảm bảo đủ phạm vi bao phủ của mô hình, nhóm phát triển đã phù hợp với phạm vi hoạt động của thiết bị GPU gốc TensorFlow, triển khai hầu hết các hoạt động quan trọng về hiệu suất bằng cách gọi các nguyên thủy học sâu được tối ưu hóa cao từ Thư viện mạng thần kinh sâu oneAPI (oneDNN). Các hoạt động khác được thực hiện với hạt nhân SYCL hoặc thư viện toán học Eigen tới C ++ với SYCL để nó có thể tạo ra các chương trình để thực hiện các hoạt động thiết bị.

- Tối ưu hóa đồ thị: Trình cắm GPU Flex Series tối ưu hóa đồ thị TensorFlow trong Grappler thông qua API Đồ thị C và giảm tải các phân vùng đồ thị quan trọng về hiệu suất cho thư viện oneDNN thông qua API Đồ thị oneDNN. Nó nhận được một đồ thị được tuần tự hóa protobuf từ TensorFlow, giải mã hóa đồ thị, xác định và thay thế các đồ thị con thích hợp bằng một op tùy chỉnh và gửi đồ thị trở lại TensorFlow. Khi TensorFlow thực thi biểu đồ đã xử lý, các hoạt động tùy chỉnh được ánh xạ tới triển khai được tối ưu hóa của oneDNN cho các phân vùng Đồ thị oneDNN được liên kết của chúng.

- API Profiler C cho phép PluggableDevices giao tiếp dữ liệu hồ sơ ở định dạng hồ sơ gốc của TensorFlow . Trình cắm thêm GPU dòng Flex lấy một đối tượng XSpace được tuần tự hóa từ TensorFlow, lấp đầy đối tượng bằng dữ liệu thời gian chạy thu được thông qua giao diện thiết bị cấp thấp oneAPI Level Zero và trả đối tượng về TensorFlow. Người dùng có thể hiển thị hồ sơ thực thi của các hoạt động cụ thể trên GPU The Flex Series bằng các công cụ lập hồ sơ của TensorFlow như TensorBoard.

Nguồn : wccftech

KhoServer – Kho Máy Chủ Thanh Lý Chuyên cung cấp và máy chủ cũ giá rẻ, máy trạm cũ, linh kiện máy chủ (cpu cũ, main cũ, ram cũ) và các thiết bị mạng giá rẻ (networking).