Tin Công Nghệ

AMD Instinct MI350 AI series cạnh tranh với Blackwell

AMD đang từng bước khẳng định vị thế của mình thông qua dòng sản phẩm Instinct MI350 series trong bối cảnh Cạnh tranh khốc liệt giữa các nhà sản xuất chip AI. Đây là thế hệ tăng tốc AI kế nhiệm MI300, được thiết kế không chỉ để đuổi kịp mà còn nhằm vượt mặt những gã khổng lồ như NVIDIA – vốn đang thống trị với kiến trúc Blackwell!

Mục Lục

- 1 Sử dụng kiến trúc CDNA 4

- 2 Bộ nhớ HBM3E và khả năng xử lý vượt trội

- 3 Bứt phá về hiệu năng AI vàinference

- 4 Chiến lược tiết kiệm năng lượng

- 5 Triển khai thực tế trong các hạ tầng đám mây và AI rack

- 6 Phần mềm ROCm và hệ sinh thái phát triển mở

- 7 Triển vọng dài hạn và định vị AMD trong tương lai AI

- 8 Lời kết

Sử dụng kiến trúc CDNA 4

Dòng MI350 được xây dựng dựa trên kiến trúc CDNA thế hệ thứ 4, đi kèm quy trình sản xuất 3 nanomet tiên tiến. Đây là lần đầu tiên AMD áp dụng tiến trình 3nm trong dòng GPU trung tâm dữ liệu của mình, cho phép tăng mật độ transistor đồng thời giảm điện năng tiêu thụ đáng kể. So với thế hệ MI300X tiền nhiệm, MI350 không chỉ là một bản nâng cấp đơn thuần mà là sự thay đổi toàn diện về hiệu suất tính toán, bộ nhớ và khả năng hoạt động ở quy mô lớn.

Đặc biệt, CDNA 4 được tối ưu hóa cho khối lượng công việc AI, thay vì phục vụ các tác vụ đồ họa truyền thống như kiến trúc RDNA trên các dòng GPU chơi game. Điều này đồng nghĩa với việc toàn bộ năng lực xử lý của MI350 được dồn vào hiệu suất tính toán song song, khả năng xử lý tensor và các định dạng số chuyên dụng như FP16, FP8, FP6 hay FP4 – những yếu tố cốt lõi trong việc huấn luyện và suy diễn các mô hình AI hiện đại.

Máy chủ DL360 Gen11 chính hãng tại Máy Chủ Việt

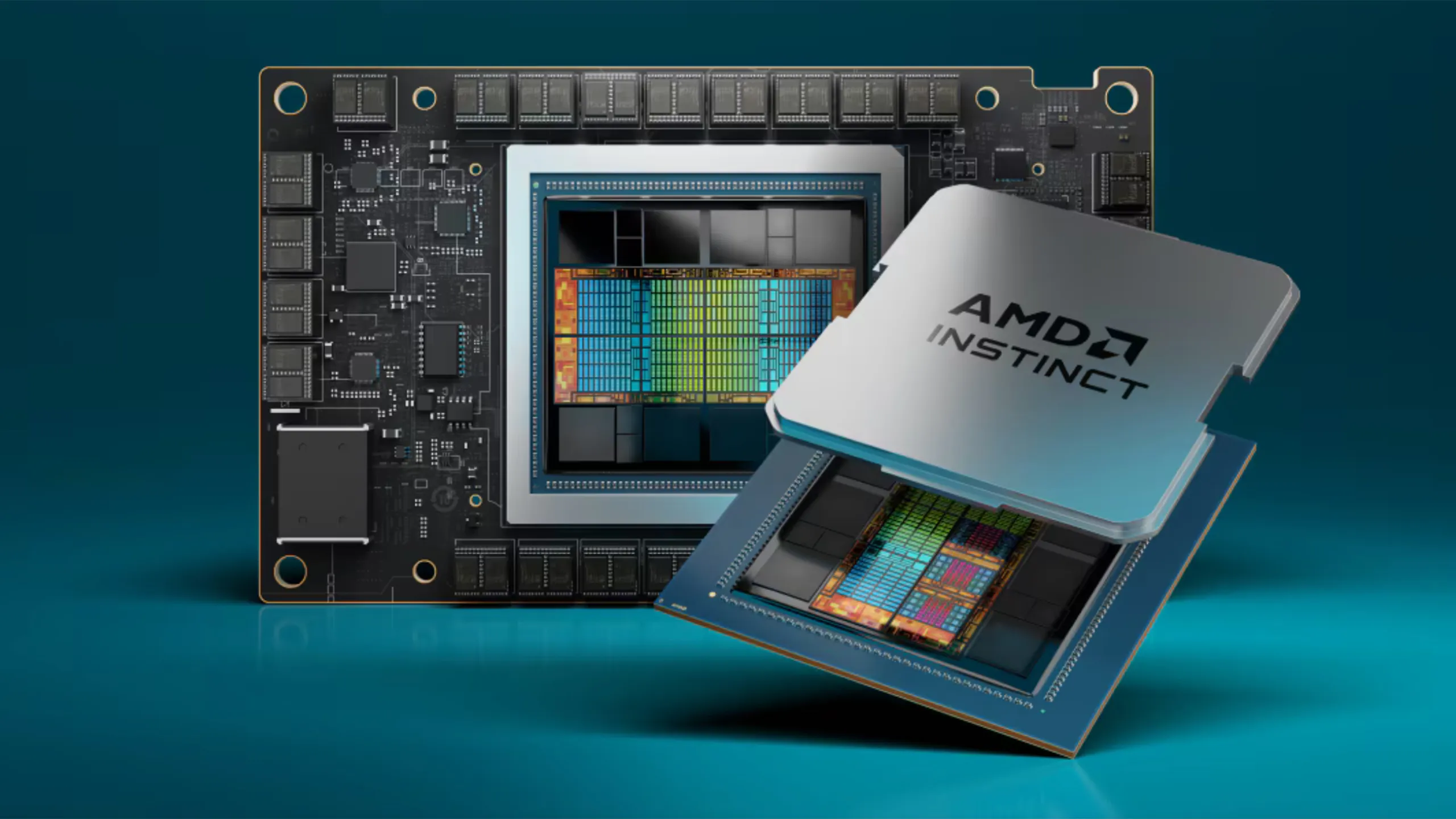

Bộ nhớ HBM3E và khả năng xử lý vượt trội

Một trong những yếu tố nổi bật của dòng Instinct MI350 chính là việc tích hợp bộ nhớ HBM3E với dung lượng lên đến 288 GB. Đây là con số vượt xa tiêu chuẩn thông thường của các bộ tăng tốc hiện nay và mở ra khả năng lưu trữ cũng như xử lý khối lượng dữ liệu cực lớn trong bộ nhớ gần. Tốc độ truyền dữ liệu trong MI350 cũng được đẩy lên mức đáng kinh ngạc, với băng thông có thể đạt khoảng 22 terabyte mỗi giây. Trong những bài toán AI yêu cầu phân tích mô hình ngôn ngữ lớn hay đa modal như hình ảnh kết hợp văn bản, sự khác biệt về băng thông và dung lượng bộ nhớ như thế sẽ tạo ra khoảng cách rõ rệt về hiệu suất.

Việc sử dụng HBM3E không chỉ mang lại tốc độ cao mà còn giảm độ trễ, đồng thời tiết kiệm điện năng hơn so với DRAM truyền thống. Đây là bước tiến rõ ràng nhằm hướng đến các trung tâm dữ liệu hiệu quả hơn, trong bối cảnh chi phí vận hành hạ tầng AI đang ngày càng tăng cao.

Bứt phá về hiệu năng AI vàinference

Một trong những cam kết đáng chú ý của AMD khi giới thiệu MI350 là khả năng suy diễn AI nhanh gấp 35 lần so với dòng MI300X trước đó. Con số này không chỉ đơn thuần là nâng cấp hiệu suất, mà còn là minh chứng cho sự chuyển mình quyết liệt nhằm cạnh tranh với dòng GPU Blackwell của NVIDIA. Trong khi Blackwell đang được tung hô với các thông số cực mạnh ở chế độ FP16 sparse hoặc FP8, AMD lại tập trung vào việc tối ưu hóa inference trong điều kiện thực tế – nơi các doanh nghiệp triển khai mô hình đã huấn luyện để phục vụ hàng triệu người dùng cùng lúc.

Hiệu năng suy diễn là thước đo quan trọng đối với hầu hết dịch vụ AI thương mại. Những mô hình như ChatGPT, Claude, Gemini hay Mistral đều yêu cầu tốc độ phản hồi nhanh, độ trễ thấp và hiệu suất cao để xử lý đồng thời nhiều phiên bản người dùng. Chính vì thế, nếu con số 35 lần nâng cấp inference của MI350 là chính xác, đây sẽ là bước đột phá đáng kể đưa AMD trở lại đường đua một cách sòng phẳng hơn bao giờ hết.

Chiến lược tiết kiệm năng lượng

Bên cạnh việc cải thiện hiệu năng, MI350 còn hướng đến mục tiêu tăng hiệu quả sử dụng năng lượng. AMD cho biết dòng chip mới này sẽ đạt được mức tiết kiệm điện năng gấp 30 lần so với thế hệ MI200. Đây không phải là một yếu tố phụ, mà là nhân tố sống còn đối với các trung tâm dữ liệu AI hiện đại. Khi mỗi rack máy chủ có thể tiêu thụ hàng chục kilowatt, thậm chí megawatt nếu quy mô đủ lớn, việc cải thiện hiệu suất năng lượng sẽ trực tiếp giảm chi phí vận hành hằng tháng cho doanh nghiệp.

Tiết kiệm năng lượng cũng đồng nghĩa với việc dễ dàng mở rộng quy mô hạ tầng hơn. Nếu một trung tâm dữ liệu có thể vận hành thêm hàng trăm GPU mà không cần nâng cấp hệ thống làm mát hay nguồn điện, đó là lợi thế cạnh tranh rất lớn trong việc triển khai dịch vụ AI thương mại với tốc độ nhanh hơn.

Triển khai thực tế trong các hạ tầng đám mây và AI rack

Dòng MI350 không chỉ tồn tại dưới dạng con chip trên giấy mà đã được tích hợp trong các thiết bị thực tế. Một ví dụ điển hình là rack AI do Pegatron phát triển, chứa đến 128 GPU MI350X với tổng bộ nhớ HBM3E lên tới gần 37 TB và sức mạnh tính toán FP4 đạt tới 1.177 PFLOPS. Đây là con số khổng lồ đủ để xử lý hàng trăm mô hình AI lớn hoạt động song song.

Mặc dù không sử dụng công nghệ NVLink độc quyền như NVIDIA, AMD lựa chọn phương pháp kết nối thông qua mạng Ethernet tốc độ cao, cho phép ghép nối nhiều GPU một cách linh hoạt và mở rộng dễ dàng. Điều này cho thấy AMD đang theo đuổi một hướng đi mở hơn, không ràng buộc khách hàng vào hệ sinh thái đóng mà vẫn đảm bảo hiệu suất hoạt động cao.

Bên cạnh đó, các nền tảng đám mây như Cirrascale cũng đã bắt đầu tích hợp MI350 vào cơ sở hạ tầng, cho phép khách hàng doanh nghiệp truy cập từ xa, thử nghiệm mô hình, và triển khai dịch vụ AI mà không cần đầu tư phần cứng ban đầu. Đây là hướng tiếp cận linh hoạt phù hợp với chiến lược phát triển phần mềm như dịch vụ (SaaS, PaaS) đang phổ biến hiện nay.

Phần mềm ROCm và hệ sinh thái phát triển mở

Phần cứng mạnh mẽ sẽ không thể phát huy nếu không có phần mềm tương thích đi kèm. AMD hiểu rõ điều này và đã không ngừng nâng cấp nền tảng phần mềm ROCm – bộ công cụ lập trình song song hỗ trợ các định dạng tính toán AI hiện đại nhất. ROCm hiện đã hỗ trợ tốt các framework phổ biến như PyTorch, TensorFlow, và Hugging Face Transformers, giúp các nhà phát triển dễ dàng chuyển mô hình từ GPU NVIDIA sang AMD mà không cần viết lại toàn bộ mã nguồn.

Ngoài ra, AMD cũng tập trung xây dựng thư viện AI tối ưu hóa, hỗ trợ tăng tốc suy diễn và huấn luyện mô hình với hiệu suất cao hơn. Đây là cách tiếp cận phù hợp trong bối cảnh nhiều công ty đang cân nhắc lựa chọn GPU thay thế nhằm tránh sự phụ thuộc tuyệt đối vào NVIDIA, đặc biệt khi tình trạng khan hiếm GPU vẫn chưa được giải quyết triệt để.

Triển vọng dài hạn và định vị AMD trong tương lai AI

Sự ra mắt của MI350 không chỉ là một sản phẩm đơn lẻ mà nằm trong chiến lược tổng thể của AMD trong việc mở rộng ảnh hưởng trong thị trường AI. Công ty đã công bố roadmap dài hạn với thế hệ MI400 dự kiến ra mắt vào năm 2026, dựa trên kiến trúc CDNA 5 và tiếp tục sử dụng quy trình sản xuất tiên tiến. Đây sẽ là bước tiếp theo trong hành trình phát triển bộ tăng tốc AI với hiệu năng và hiệu suất năng lượng ngày càng cao.

Server Dell T360 vẫn sẵn hàng chờ khách hàng alo

Không chỉ dừng lại ở phần cứng, AMD còn mở rộng năng lực cung ứng thông qua việc thâu tóm các công ty như ZT Systems – nhà sản xuất hệ thống máy chủ, nhằm xây dựng các giải pháp AI end-to-end. Bằng cách kiểm soát cả chip lẫn phần cứng xung quanh, AMD sẽ có khả năng cạnh tranh tốt hơn với NVIDIA, vốn đã có hệ sinh thái rất mạnh gồm GPU, NVLink, DPU và phần mềm CUDA.

Lời kết

Instinct MI350 là minh chứng cho sự trỗi dậy mạnh mẽ của AMD trong lĩnh vực trí tuệ nhân tạo. Với những cải tiến đáng kể về kiến trúc, bộ nhớ, hiệu năng inference và khả năng tiết kiệm năng lượng, dòng chip này đang từng bước trở thành đối trọng thực sự với Blackwell của NVIDIA. Không chỉ dừng lại ở thông số kỹ thuật, MI350 còn được triển khai thực tế trong các hệ thống rack và nền tảng đám mây – điều chứng minh rằng đây không còn là một ý tưởng, mà là giải pháp sẵn sàng cho thị trường.

Nguồn: Wccftech